Dans les pays industrialisés, pas un scrutin majeur ne se déroule désormais sans l’assistance d'algorithmes prédictifs, des systèmes d’analyse des données qui permettent d’anticiper le choix des électeurs, dans l'espoir de le modifier. En France, l’équipe d’Emmanuel Macron, notamment, y recourt de manière généralisée.

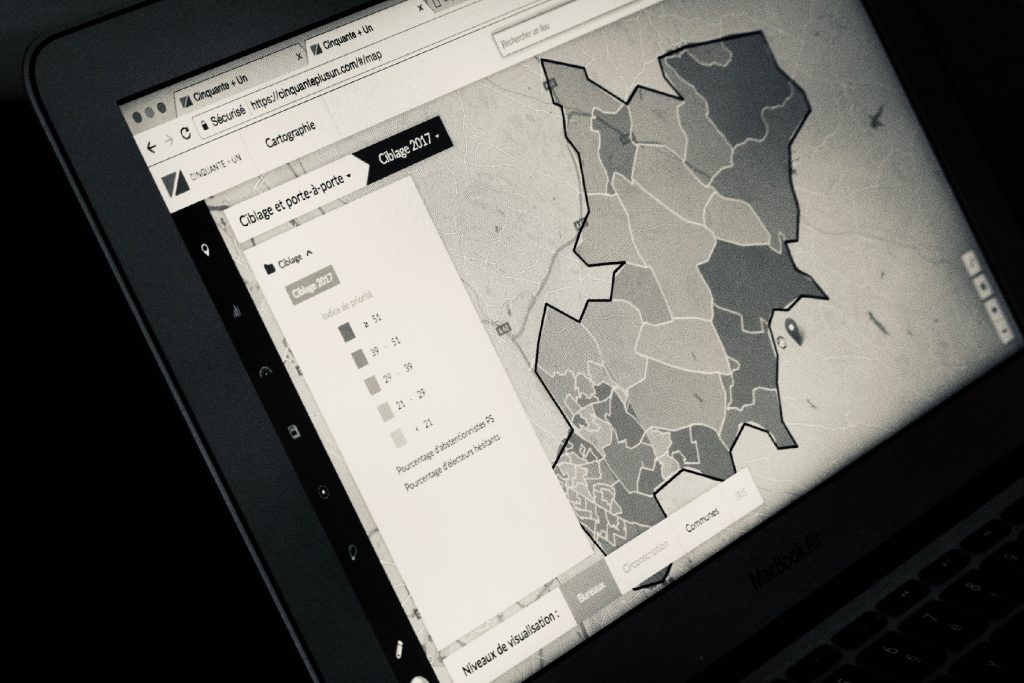

Cas pratique. Une ville de 50.000 habitants : Chelles, en Seine-et-Marne. Quelques jours avant le deuxième tour des législatives de 2017. Des militants arpentent les rues, ils vont à la rencontre des électeurs, un œil sur une tablette numérique. Ils ne se déplacent pas au hasard ; sur l'écran, une application baptisée "50+1" les guide. Pour chaque pâté de maisons de la commune, le système calcule le potentiel des voix que leur candidat peut recueillir, en comparant son positionnement politique avec les caractéristiques de la population. Ici, un quartier a apporté le maximum des suffrages escomptés, inutile de s'y rendre. Là, les derniers résultats se révèlent en deçà des prévisions. Les militants se dirigent en priorité vers ces résidences-ci, où ils espèrent encore gagner des votes. Avant de frapper à la première porte, ils zooment sur la cartographie de l'application. Au regard de la catégorie sociale des familles vivant ici, ils adaptent leur discours, sélectionnent les espoirs et les peurs à évoquer avec leurs interlocuteurs. Le 18 juin 2017, au soir de ces élections législatives, sur 577 députés victorieux, 129 avaient mené campagne à l'aide de ce système vendu par abonnement, soit 22% de la nouvelle Assemblée nationale.

Ce produit numérique, "50 + 1", repose sur une base de données privilégiant la géographie. Elle fractionne la France en 67.000 quartiers, correspondant précisément à 67.000 bureaux de vote. A l'intérieur de ce découpage, elle mixe les chiffres de l'Insee – l'âge, la composition des familles, les revenus, le niveau d'études, le type d'emploi – avec les résultats enregistrés dans tous ces bureaux de vote, sur cinq à huit ans. Branché à un algorithme prédictif, le dispositif permet de modéliser, quartier par quartier, le comportement électoral des citoyens, dans le but de l'influencer.

Selon une narration bien huilée, l'outil est commercialisé par une audacieuse start-up créée en octobre 2012 : LMP. Pour Liegey, Muller et Pons, du nom des trois fondateurs, anciens copains de fac aux Etats-Unis, où ils ont découvert les méthodes de l'équipe d'Obama, avant de rentrer à Paris "pour épauler les partis de progrès".

Avec, à l'appui, de solides réseaux. Il y a trois ans, le 31 juillet 2014, la société a procédé à une augmentation de capital et accueilli 29 nouveaux actionnaires, dont un expert ministériel en matière de big data et une proportion significative de futurs conseillers ou proches soutiens d'Emmanuel Macron. Tels Florian de Botman, ex-conseiller open data auprès de la secrétaire d’État chargée du Numérique, Axelle Lemaire ; Charles-Henri Weymuller, nommé il y a peu conseiller économique à l’Élysée ; Karim Tadjeddine, associé à la rédaction du programme d'Emmanuel Macron et responsable du pôle secteur public au sein du cabinet McKinsey ; Margaux Bergeon-Dars, nommée conseillère du nouveau ministre des Affaires étrangères ; Stéphane Boujnah, président du directoire d'Euronext et ancien membre du cabinet de Dominique Strauss-Kahn ; ou encore Jean-Noël Barrot, fils de l'ancien ministre Jacques Barrot, élu député des Yvelines en juin sous les bannières du MoDem et d'En marche!, et depuis peu vice-président de la commission des finances de l'assemblée. Nombre de start-up rêveraient pareil parrainage.

Joint par téléphone à l'université de Harvard, Vincent Pons, 34 ans, cofondateur de l'entreprise et professeur expert en "comportement électoral", évoque après un moment de gêne la nature amicale, voire familiale, des relations entre ces personnes, et leurs points de convergence. À des degrés divers, dans les univers académiques ou financiers, la plupart se passionnent pour le big data (ces masses de données numériques trop volumineuses pour être analysées par les systèmes de gestion classiques) et la politique. Lui se concentre sur la fabrication d'algorithmes prédictifs, tels ceux utilisés à Paris, rue du Chemin-Vert, sur les serveurs de la société.

Sa démarche est inspirée des travaux de l'un de ses éminents collègues et voisins de labo à Harvard, Gary King, expert des statistiques appliquées aux sciences sociales. "D'abord, indique-t-il, les données que nous associons sont agrégées, rendues anonymes", comme la loi le requiert en France ; puis "on cherche à identifier les trajectoires individuelles, les reports de voix, les suffrages à gagner". Dans le jargon, entre savants, on parle "d'algorithme d'inférence écologique."

A Paris, l'associé de Vincent Pons, Guillaume Liegey, se charge notamment de commercialiser ce savoir-faire. "Notre force, c'est d'indiquer avec précision dans quels endroits les efforts doivent porter, avec quels arguments selon les programmes", affirme-t-il. Outre la France, la start-up intervient notamment en Allemagne, au Brésil et en Tunisie. Et avec le temps, le trio d'entrepreneurs espère bien améliorer son offre. En ce moment, LMP planche sur l'intégration des messages diffusés sur les réseaux sociaux, avec le projet de les géolocaliser, par exemple, pour les posts publiés sur Facebook, afin d'accroître encore ses capacités de prédiction dans les 67.000 quartiers en analysant ce qui s'y dit en ligne. Quitte à préoccuper les gardiens des libertés publiques.

Car ces innovations n'échappent pas à la Commission nationale de l'informatique et des libertés (Cnil). Lors de l'ouverture de la campagne présidentielle de 2017, puis de celle des législatives, elle a adressé des recommandations aux divers partis et animé un Observatoire des élections, destiné à prévenir les éventuelles dérives. Si pour l'heure, aucun manquement n'a été publiquement constaté, les services de la Cnil, sollicités par le JDD, n'ont pas souhaité commenter les contrôles auxquels ils procèdent en ce moment. Dans un e-mail, ils évoquent des "logiciels de prospection électorale encore assez méconnus", vis-à-vis desquels ils ont "adopté pendant les élections une démarche de pédagogie". Et annoncent pour "l'automne un bilan couvrant toute la période électorale depuis octobre 2016 et les premières primaires" qui comportera "un approfondissement des logiciels de marketing politique".

Aux États-Unis, les campagnes de Barack Obama en 2008 et 2012 avaient, les premières, expérimenté ces outils sur une large échelle. À l'époque, les espoirs nés de son élection avaient paré de toutes les vertus les moyens employés, en particulier ceux proposés par une société de Washington, Catalist LLC, et par sa base de données du même nom, particulièrement vorace en informations privées, voire intimes. En Amérique, les données des citoyens ne sont protégées que de manière marginale par le législateur. Alimentée depuis 2006, Catalist, dirigée par une ancienne adjointe d'Al Gore à la Maison-Blanche, croise et analyse les détails financiers, commerciaux et électoraux de 240 millions d'électeurs américains, le plus souvent de manière nominative. Éludant son caractère tentaculaire, les évangélistes du big data au service de causes dites progressistes en ont fait peu ou prou une référence.

Huit ans plus tard, ces technologies se sont durablement installées. Référendum sur le Brexit, élection de Donald Trump, élection d'Emmanuel Macron, législatives britanniques, législatives françaises : depuis un peu plus d'un an, pas un de ces rendez-vous électoraux majeurs ne s'est déroulé sans l'assistance de sociétés expertes en analyses de données. Évidemment, l'armada d'électronique qu'elles utilisent, en lisière du processus démocratique, nourrit craintes et fantasmes. Cibler ainsi les électeurs, percer leurs intentions pour conforter leur choix ou, au contraire, les faire douter, n'y a-t-il pas là un risque de dévoiement du jeu électoral ?

Lors de la dernière présidentielle américaine, une société d'origine britannique, Cambridge Analytica, a alarmé les défenseurs des libertés publiques. Elle a été mandatée par l'équipe de campagne de Donald Trump afin de déployer ses algorithmes prédictifs pour comprendre et anticiper les réactions des électeurs peu avant le scrutin. Cette drôle de start-up, qui emploie pas moins de cent personnes à temps plein, trouve son origine dans les activités d'un industriel proche des services de renseignement et des milieux de la défense, SCL Group, spécialisé dans la gestion des flux d'informations pour le compte des militaires. Sur le site de l'Otan, on peut ainsi parcourir le rapport d'un officier de la Royal Navy, expert en opérations psychologiques, vantant les solutions développées par SCL Group en Afghanistan, afin d'y gagner le cœur des Afghans – avec des résultats mitigés, semble-t-il.

À Londres, cette filiation avec SCL Group apparaît à la lecture du registre des sociétés britanniques, dans les documents déposés le 6 janvier 2015 au moment de l'enregistrement de Cambridge Analytica. Nous avons contacté le fondateur de cette dernière, Alexander Nix, par ailleurs directeur de huit filiales de SCL Group, et avons pu nous entretenir avec l'un de ses adjoints, Nick Fievet. Dans nos échanges, celui-ci a surtout minimisé leur rôle joué dans la campagne de Donald Trump. "Nous conduisons des recherches pour connaître les audiences, en combinant nos données avec celles de nos clients, afin de bâtir des modèles prédictifs", détaille-t-il. Mais sans que cette intervention présente un caractère crucial, s'empresse-t-il d'ajouter : "Il est important de comprendre que ce sont les candidats qui gagnent les élections, pas la science des données."

Malgré les croisements entre big data, prestations paramilitaires et marketing électoral desquels procède Cambridge Analytica, une analyse fouillée, parue le 8 juin dans la prestigieuse New York Review of Books, corrobore le rôle modeste qu'elle se donne dans la course à la Maison-Blanche. Mais au profit, selon l'auteur, de deux bases de données concurrentes et de leurs algorithmes prédictifs, également mis à la disposition de l'équipe Trump – Voter Vault et Project Alamo, plus anciens et mieux fournis – ainsi que des solutions particulièrement agressives déployées sur Facebook par le responsable digital de sa campagne, Brad Parscale.

Pour l'heure, c'est finalement en Grande-Bretagne que les gardiens des données privées se montrent les plus méfiants vis-à-vis de l'arrivée de ces technologies dans l'espace politique. Depuis la secousse provoquée par le Brexit, le concubinage entre bases de données, algorithmes prédictifs et campagnes électorales suscite un vif débat : faut-il fixer des limites au plus puissant instrument de conquête, la persuasion ? L'équivalent anglais de la Cnil, l'Information Commissioner's Office (ICO), a ouvert une enquête le 17 mai sur l'utilisation de ces outils au cours des dernières élections. Son chargé de communication, Steve Doohan, nous a confirmé que ces investigations portaient sur plusieurs sociétés ayant fourni des données à des partis politiques, et notamment sur Cambridge Analytica, cette fois pour ses activités sur le sol du Royaume-Uni. La Commission électorale britannique, de son côté, mène des audits sur des contrats passés par le camp du Brexit, en particulier avec une société canadienne spécialisée dans les analyses prédictives, AggregateIQ. Tous les spécialistes n'adhèrent pas à ces interrogations alarmistes.

La sociologue Angèle Christin, de son côté, dit observer sans anxiété l'évolution récente. Ses travaux portent sur les effets des technologies du numérique et sur l'impact des big data dans nos sociétés. Après une thèse remarquée ("Clicks or Pulitzers?", soutenue à Princeton et à l'EHESS), qui sondait avec justesse la tendance des journalistes à privilégier leur gloire personnelle et leur popularité en ligne, elle étudie maintenant les conséquences de l'utilisation des algorithmes prédictifs dans le monde professionnel. Au cœur de la Silicon Valley, depuis l'université de Stanford, où elle a été nommée, elle examine comment des lignes de code peuvent influencer des administrations. Elle confie au JDD ses doutes quant aux pouvoirs prêtés à ces outils de prévision : "De nos jours, quand on ne sait pas quoi faire, on s'en remet aux algorithmes. Dans le fond, ils sont perçus comme une solution à un moment où les sociétés doutent de leur processus de décision."

À l'entendre, les acteurs du jeu politique y auraient recours autant par dépit, par manque d'idées, que pour répondre à un phénomène de mode. De quoi relativiser, a priori, leur incidence. D'autant que lors des échéances électorales, la communication politique, omniprésente, peut amplifier artificiellement des actions ou des propos. "Les organisations essaient toujours d'envoyer des signaux de modernité, note la sociologue. Personne n'affirmera qu'il ne recourt que modérément au numérique ou qu'il n'utilise pas le big data."

Ainsi, en France, en ce qui concerne trois des candidats favoris au premier tour de la présidentielle – Emmanuel Macron, Marine Le Pen et Jean-Luc Mélenchon –, la modernité qu'ils affichaient en existant sur les réseaux sociaux leur a peut-être autant bénéficié que le contenu des messages mêmes qu'ils y délivraient. "La réalité est à nuancer, insiste Angèle Christin. Plusieurs officines vendent aux partis politiques des solutions de big data avec des algorithmes prédictifs, telles que Cambridge Analytica aux Etats-Unis ou LMP en France. Mais il y a, je pense, des effets d'affichage."

Une question nous brûle cependant les lèvres. En lisant les statuts et les procès-verbaux déposés au tribunal de commerce, on constate qu'Angèle Christin figure elle-même parmi les actionnaires de LMP. Une présence qui invite à relativiser ses propres nuances au sujet de l'intérêt des algorithmes prédictifs. Elle tempère : "On se connaît depuis longtemps, ce sont des camarades de promo pour certains. On s'intéresse tous au potentiel du big data." Évidemment.

Ce reportage a fait l'objet d'une première parution dans Le Journal du dimanche du 2 août 2017.